Im Projekt „Virtual LiVe“ arbeiten die drei Fraunhofer-Institute Fokus, HHI und IIS mit der Kreativwirtschaft und Unternehmen aus der Veranstaltungsbranche zusammen. Gemeinsam realisierten sie im Rahmen des Projekts ihr erstes experimentelles Laborkonzert. Am 11. Dezember 2021 fand die Veranstaltung zeitgleich an verschiedenen Orten statt und sollte die Vorteile des Einsatzes von immersiver Medientechnik in klassischen Veranstaltungsformaten demonstrieren.

Im ersten Quartal 2021 hatten sich die Projektpartner Fraunhofer Fokus, Fraunhofer HHI und Fraunhofer IIS auf den Weg gemacht, um hybride Live-Events mit modernsten immersiven Technologien zu erweitern und aufzuwerten. Ziel war es, die Grenzen zwischen physischer und digitaler Wahrnehmung zu verwischen. Dafür sollten High-End-Technologien von Fraunhofer eingesetzt und miteinander verknüpft werden, um so die Digitalisierung klassischer Veranstaltungsformate zu optimieren.

Gemeinsam luden die Projektpartner zu Beginn des Projekts alle Stakeholder ein, analysierten Dutzende von Fragebögen und führten Workshops und Kolloquien durch, um die genauen Bedürfnisse der Branche zu ermitteln. Die Ergebnisse führten zur Realisierung des ersten hybriden Live-Events des Projekts: In Zusammenarbeit mit dem Künstler The Dark Tenor fand die Veranstaltung schließlich im Kesselhaus der Kulturbrauerei Berlin, im Planetarium Bochum, im digitalen Kino des Fraunhofer IIS und online statt. Ein Making-of-Video zum Event gibt es hier.

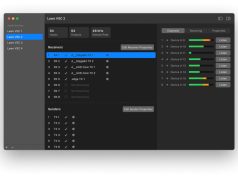

Der Künstler Billy Andrews gab das Premierenkonzert seiner Classic Roxx Tour im Kesselhaus in Berlin. Rund 150 Gäste erlebten die Show vor Ort mit der kompletten Bandbesetzung von The Dark Tenor. Begleitet wurde er von Queenz of Piano, die aus dem StudioMix, einer anderen Location in Berlin, spielten. Sie wurden über eine Ultra-Low-Latency-Audioverbindung durch die Digital Stage Plattform in das Konzert eingebunden. Die Queenz of Piano wurden zusätzlich aus ihrem Studio auf eine Leinwand im Kesselhaus projiziert.

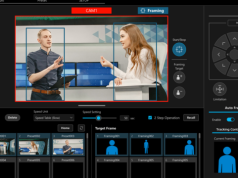

Die Veranstaltung im Berliner Kesselhaus wurde mit der Panoramakamera OmniCam aufgezeichnet, einem skalierbaren, spiegelbasierten Multikamerasystem, das zusammen mit seiner Real Time Stitching Engine (RTSE) in der Lage ist, einen hochauflösenden 360°-Videostream aufzunehmen und in Echtzeit zu übertragen. Im Planetarium Bochum wurden die Videobilder der 4K-Nahaufnahmekameras mit denen der 360°-Kamera mittels einem speziellen DomePlayer kombiniert und in Echtzeit geometrisch an die Kuppelform angepasst, um dann in der 6Kx6K-Kuppelprojektion des Planetariums mit den elf vorhandenen hochauflösenden Projektoren dargestellt zu werden.

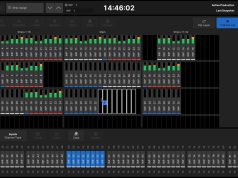

Je nach Song wurde diese Projektion mit planetariumspezifischen Inhalten wie Kuppelbeleuchtungseffekten oder dem gestochen scharfen Sternenhimmel des Zeiss-Sternenprojektors angereichert. Alle auf der Projektion dargestellten Videomedien wurden in ihren Eigenschaften wie Position, Rotation, Größe, Zoom oder Transparenz interaktiv und in Echtzeit animiert. Um das immersive Erlebnis zu vervollständigen, wurde der Konzertsound mit MPEG-H Audio produziert. Ein 3D-Audiomix wurde in Echtzeit erstellt. Mit Hilfe eines Spatial Audio Designers wurde eine MPEG-H-Szene erstellt, anschließend kodiert und in die Cloud übertragen.

Der Audio- und Videostream wurde im Planetarium dekodiert und dann auf mehr als 60 Lautsprecher in der gesamten Planetariumskuppel verteilt. Die verschiedenen Video- und Audioströme wurden frame-genau synchronisiert, um ein perfektes audiovisuelles Erlebnis zu gewährleisten. Mehr als 600 Teilnehmer aus 16 Ländern verfolgten das Konzert virtuell über das Internet. Die hier eingesetzte Famium-Dash-Lösung ermöglichte die Übertragung von Videoströmen mit niedriger Latenz und adaptiver Qualität, einschließlich akustischem oder visuellem Feedback. So konnte das entfernte Publikum das Konzert nicht nur mit einer geringen Verzögerung von wenigen Sekunden online verfolgen, sondern auch seinen Applaus in Echtzeit über digitale Emojis und Videochats an das Kesselhaus senden.

Ein Public Fan Channel, der während des Konzerts auf einer Großleinwand im Kesselhaus zu sehen war, unterstrich die Vernetzung der verschiedenen Publikumsgruppen. Darüber hinaus konnten die Zuschauenden ihre eigenen privaten Video-Chaträume einrichten und ihre Freunde einladen, das Konzert gemeinsam zu verfolgen. Zusätzlich wurde der 360-Grad-Panorama-Livestream der OmniCam, der zum Planetarium übertragen wurde, auch online für die Zuschauer zu Hause in einer Auflösung von bis zu 4K bereitgestellt. Mit diesem zusätzlichen Stream konnten die Zuschauer zu Hause im Panorama des Live-Konzerts im Kesselhaus navigieren und in die Show eintauchen.

Die MPEG-H-Audioproduktion kann von einer Vielzahl von Abspielgeräten wiedergegeben werden, sobald ein Audiomix erstellt wurde. Für das Monitoring des kodierten Signals vor Ort wurde ein Tablet eingesetzt, das den Stream aus dem Internet empfängt und für die binaurale Kopfhörerwiedergabe dekodiert. Gleichzeitig wurde derselbe Bitstrom an ein digitales Kino in Erlangen gesendet, wo Projektpartner die Show mit 3D-Sound verfolgten. Das Laborkonzert demonstrierte, inwieweit ein Produktionsworkflow, der Spitzentechnologien einsetzt, in der Lage ist, dem Publikum vor Ort, an entfernten Veranstaltungsorten wie Planetarien oder Kinos und zu Hause einen wirklich immersiven Echtzeitinhalt zu bieten.